Deep Learning Detection of Weeds in Vegetable Fields

-

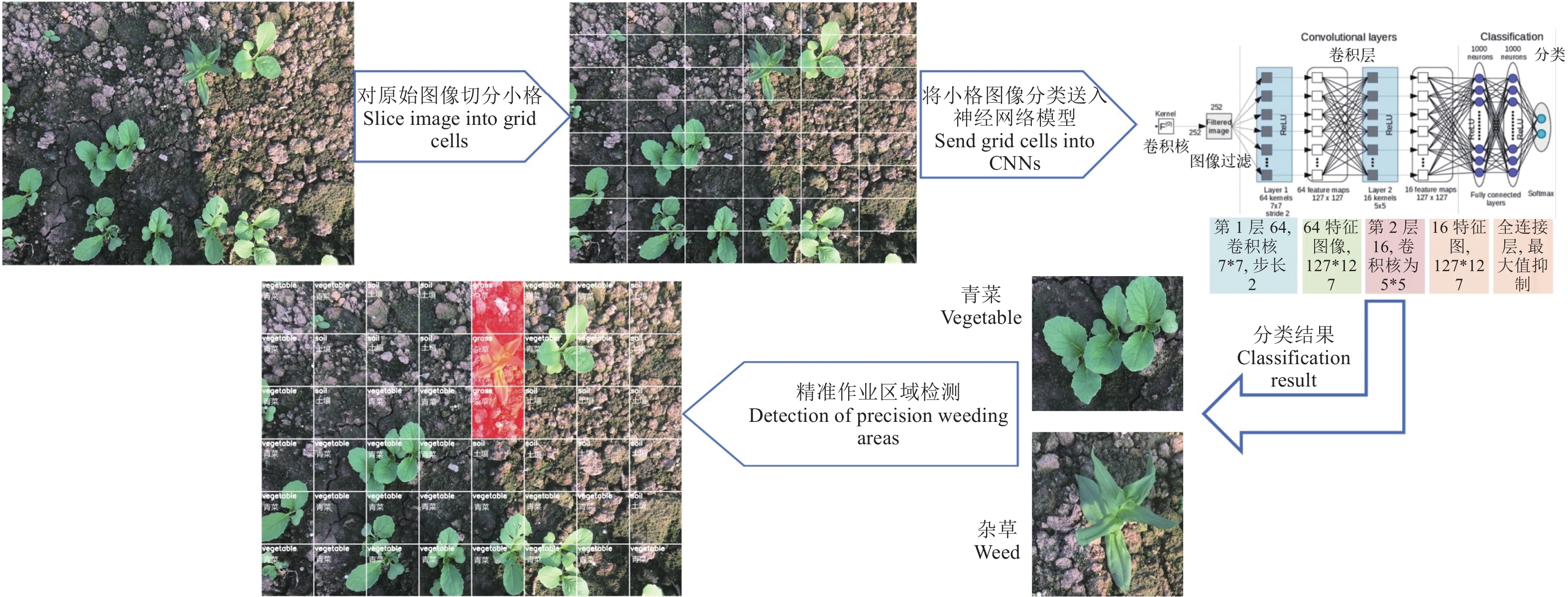

摘要:目的 蔬菜生长随机,杂草种类众多。传统杂草识别算法复杂,且仅识别出杂草,未能精准确定除草作业区域。本研究以蔬菜及其伴生杂草为研究对象,拟探索一种基于深度学习的杂草识别与精准除草作业区域检测方法。方法 通过将原图切分网格图像,利用深度学习模型识别蔬菜、杂草及土壤,将包含杂草的网格图像标记为除草作业区域。选取ShuffleNet、DenseNet和ResNet模型开展识别试验,并采用精度、召回率、F1值和总体准确率、平均准确率分别对验证集和测试集进行评价分析。结果 所选的3种网络模型均能较好地识别杂草和蔬菜,其中ShuffleNet为杂草识别最优模型,其对杂草的识别具有较为均衡的精度和召回率,分别为95.5%、97%,且其识别速度也达最优,为68.37 fps,能够应用于实时杂草识别。结论 本研究提出的除草作业区域检测方法具有高度的可行性和极佳的识别效果,可用于蔬菜田间杂草的精准防除。Abstract:Objective Deep learning to accurately identify weeds for effective weeding in vegetable fields was investigated.Method Image of a vegetable field was cropped into grid cells as sub-images of vegetables, weeds, and bare ground. Deep learning networks using the ShuffleNet, DenseNet, and ResNet models were applied to distinguish the target sub-images, particularly the areas required weeding. Precision, recall rate, F1 score, and overall and average accuracy in identifying weeds of the models were evaluated.Result Although all applied models satisfactorily distinguished weeds from vegetables, ShuffleNet could simultaneously deliver a 95.5% precision with 97% recall and a highest detection speed of 68.37 fps suitable for real-time field operations.Conclusion The newly developed method using the ShuffleNet model was feasible for precision weed control in vegetable fields.

-

Keywords:

- Vegetables /

- weeds /

- image treatment /

- deep learning /

- weeding area determination

-

0. 引言

【研究意义】我国是世界蔬菜生产和消费大国[1]。2021年我国蔬菜播种总面积为21 872.21 hm2,总产量约为76 710.8万t[2]。蔬菜是我国种植产业的重要组成部分,同时也是农业发展的重要产业支柱。杂草与蔬菜争夺阳光、水分、养料,引发病虫鼠害,降低蔬菜的产量与质量[3]。据统计,我国约有杂草1 500余种,其中130多种严重危害作物生长[4]。目前杂草防除方法主要有人工除草、化学除草、机械除草及生物除草等[5−8]。人工除草耗时、费力,随着人工成本的增加及规模化管理的普及[9],人工除草已不适用于现代蔬菜业的管理模式。化学除草可以有效控制杂草的生长,但过量使用易造成农药残留,同时在生物循环过程中也会对土壤、水源等造成污染[10−11]。随着精准农业技术的发展,越来越多的研究投入到智能化除草技术中[12−13]。精准的杂草识别及除草作业区域检测是实现杂草精准防除的前提与关键[14−15]。【前人研究进展】传统杂草识别方法多集中于研究植物的颜色、形状、纹理特征,或利用空间分布特征、多光谱特征等[16−18]。相关研究取得了诸多进展,但仍存在着算法复杂、泛化能力不足等问题[19−20]。随着人工智能技术的快速发展[21],深度学习被广泛应用于农业杂草识别。国内外学者陆续开展了基于深度学习的杂草识别研究。Osorio等[22]分别采用SVM-HOG、YOLO-v3和Mask R-CNN算法识别杂草,通过将二元掩模与NDVI运算结果相混合,从而提取杂草目标并计算覆盖率,结果表明,所选3种算法相对人工计算准确率显著提高。彭文等[23]以水稻田间杂草为研究对象,对比分析ResNet50、VGG16、DenseNet169等多种深度卷积神经网络。结果表明,VGG16精度最佳。Yu等[24−26]研究发现VGGNet和DetectNet模型均能有效识别休眠期狗牙根草坪中的各类单子叶和双子叶杂草。金小俊等[27−29]开展苗期青菜及其伴生杂草的识别,通过选取多种结构模型进行对比试验,并对超绿因子加以改进,有效提高了杂草识别率。【本研究切入点】前人的研究主要集中于识别不同种类的杂草[30],然而杂草种类繁多,直接识别工作量大、技术复杂且难以对每类杂草都保持高识别率。另一方面,当前研究仅能识别出杂草,未能确定除草作业区域,难以直接集成相关算法至智能化除草装备。【拟解决的关键问题】以青菜及其伴生杂草为研究对象,探讨一种基于深度学习的杂草识别与除草作业区域检测方法,为实现精准除草提供理论基础。

1. 材料与方法

1.1 图像采集

研究对象为苗期青菜及其伴生杂草。苗期青菜图像于2022年5月和10月分两批采集于江苏省南京市栖霞区某一蔬菜园中,图像原始分辨率为1792 像素×1344像素,共采集图像2812张。为保证深度学习训练样本的多样性,图像采集在阴天和晴天等不同光线条件下进行。

1.2 深度学习训练集

训练集图像数据为原图切分后的网格图像。每张原图按照6行8列切分为48张网格图像(图1),切分后的网格图像分辨率为224×224像素。在实际应用中,存在杂草的网格即可标记为除草作业区域。

对切分后的网格图像进行人工分类。其中,包含青菜的网格图像为正样本,包含杂草和土壤的为负样本。共计选取正样本4 000张,负样本8 000张。正样本中随机选取3 000张青菜网格图像作为训练集,另各随机选取500张网格图像作为验证集和测试集(表1)。负样本分为杂草和土壤图像,其中杂草图像包含禾本科杂草和阔叶草。负样本数据集划分同正样本。

表 1 深度学习数据集Table 1. Dataset of deep learning models样本类别

Sample category正样本

Positive sample负样本

Negative sample青菜

Vegetable杂草

Weed土壤

Soil训练集

Training dataset3000 3000 3000 验证集

Validation dataset500 500 500 测试集

Testing dataset500 500 500 1.3 深度学习框架

本试验采用的深度学习平台为轻量级分布式机器学习平台PyTorch[31−32]。PyTorch由Facebook研发,支持GPU加速且具有更高级的性能,为深度学习研究提供了兼具灵活性和高效能的运行框架 。深度学习运行硬件平台为台式计算机,64 G内存,处理器为Intel Core i7-7900X @ 3.30 GHz,GPU为NVIDIA GeForce RTX2060 Super,操作系统为Ubuntu 18.04。

1.4 青菜和杂草识别

1.4.1 深度学习模型

为对比不同深度学习模型对杂草识别的效果并使用最优模型进行精准除草作业区域检测,本研究选取ShuffleNet模型、DenseNet模型以及ResNet模型进行青菜和杂草识别试验。ShuffleNet是旷视科技提出的一种计算高效的卷积神经网络模型,聚焦于如何利用有限的计算资源达到最好的分类精度,其通过Pointwise Group Convolution和Channel Shuffle两种操作,在保证精度的同时大大降低模型的计算量[33]。DenseNet模型摒弃通过加深网络层数和加宽网络结构以提升网络性能的定式思维[34],从特征的角度考虑,利用特征重用和旁路设置,既大幅减少网络的参数量,又在一定程度上缓解了梯度消失问题。ResNet是由微软实验室提出的残差超深网络结构模型[35−36],使用Batch Normalization加速训练过程,优化了梯度消失、梯度爆炸和退化等问题。本研究将从识别准确率和识别速度两方面对所选模型进行综合分析与对比。各模型的超参数设置如表2所示。

表 2 不同模型的默认超参数Table 2. Hyper-parameters for training convolutional neural networks模型

Neural network批尺寸

Batch size初始学习率

Initial learning rate学习率调整策略

Learning rate policy优化器

Optimizer训练周期

Training epochsShuffleNet 16 0.001 LambdaLR SGD 24 DenseNet 16 0.001 LambdaLR SGD 24 ResNet 16 0.0001 StepLR Adam 24 1.4.2 评价指标

对于验证集,本研究采用精度(Precision,Ppre)、召回率(Recall,Prec)和F1值作为评价指标。其中精度指模型对目标正确分类的数量与真实数量的比值。召回率指模型对所有目标正确预测的比例。定义如下:

Ppre=tptp+fp (1) Prec=tptp+fn (2) 上两式中,tp代表被正确分类的正样本数量,即被正确识别的青菜数量; fp 代表被错误划分为正样本的数量,即实际为青菜但被分类为杂草或土壤的数量;fn代表被错误划分为负样本的数量,即实际为杂草或土壤但被分类为青菜的数量。

F1值是分类综合评价指标,计算方式为精度和召回率的调和平均数:

F1=2×Ppre×PrecPpre+Prec (3) 在测试集中,本研究采用总体准确率OACC(Overall accuracy)和平均准确率AACC(Average accuracy)作为评价指标。总体准确率是指在测试集中,通过模型预测正确的数量与总体数量的比值,即被正确识别的青菜、杂草或土壤的数量占总体数量的比值。其计算方式如下:

OAcc=tp+tntp+fp+tn+fn (4) 上式中,tn代表被正确分类的负样本数量,即被正确识别的杂草和土壤数量。

平均准确率是对各个分类的总体准确率求平均值,该评价指标反映了模型对所有目标的综合分类能力,其计算方式如下:

AAcc=OAccNc (5) 其中Nc代表类别数量。

1.5 除草作业区域检测

识别出杂草后需要进一步确定除草作业区域,本研究通过将原图划分为若干网格图像,继而利用深度学习模型对各网格图像进行识别,将包含杂草的网格图像标记为需要除草的区域。由于网格在原图中的位置已知,故而识别出杂草网格即可实现除草作业区域检测。在实际应用中,智能除草装备的图像采集设备获取蔬菜田间图像,随后将原图按照除草执行器的覆盖范围切分网格,使得每次除草动作可以清除单位网格图像区域。除草作业区域为所有包含杂草的网格区域,除草装备的执行器根据网格图像在原图中的位置精准移动到相应区域完成除草作业。图2展示了精准除草作业区域的检测流程。

2. 结果与分析

供试3种模型验证集评价数据如表3。从表中可知,ResNet模型对土壤的识别精度最高,达0.981。ShuffleNet模型则更善于识别青菜,精度高达0.990。识别精度越高,表示被误判的概率越低。召回率方面,DenseNet对土壤识别具有最高的召回率,达0.974,表明DenseNet对土壤识别有2.6%的漏检率。DenseNet对青菜的召回率为0.994,漏检率仅有0.6%,低于其余所选模型。F1值是神经网络识别的综合评价指标,ShuffleNet对于土壤识别的F1值略低于DenseNet,但其对青菜和杂草识别的F1值均高于DenseNet和ResNet。该数据表明ShuffleNet对于青菜和杂草的识别在精度和召回率达到了最佳平衡。而ResNet对于土壤、青菜和杂草的识别均低于其他两种模型。

表 3 不同深度学习模型验证集识别结果Table 3. Evaluation metrics on validation dataset obtained by deep learning models模型

Neural Network类别

Category精度

Ppre召回率

PrecF1值

F1 scoreShuffleNet 土壤 Soil 0.978 0.946 0.967 青菜 Vegetable 0.990 0.988 0.989 杂草 Weed 0.955 0.970 0.962 DenseNet 土壤 Soil 0.972 0.974 0.973 青菜 Vegetable 0.975 0.994 0.984 杂草 Weed 0.969 0.948 0.958 ResNet 土壤 Soil 0.981 0.946 0.963 青菜 Vegetable 0.969 0.992 0.980 杂草 Weed 0.945 0.956 0.950 表4为所选深度学习模型测试集评价结果。从表中可知,ShuffleNet对于土壤和杂草识别的总体准确率最高,对青菜识别的总体准确率与DenseNet相近,且其平均准确率最高,为0.951,该结果表明ShuffleNet整体识别效果最佳。而ResNet对3种分类的总体识别率最低,平均识别率仅为0.941。由此可见,在3种深度学习模型中,ShuffleNet的识别效果优于DenseNet和ResNet。

表 4 不同深度学习模型测试集评价数据Table 4. Evaluation metrics on test dataset obtained by deep learning models模型

Neural network类别

Category总体

准确率

OAcc平均

准确率

AAcc网格图像

识别

速度

Speed of

grid cells/fps原图识别

速度

Speed of

full images/fpsShuffleNet 土壤 Soil 0.967 0.951 207.45 68.37 青菜 Vegetable 0.978 杂草 Weed 0.957 DenseNet 土壤 Soil 0.967 0.949 104.05 58.94 青菜 Vegetable 0.979 杂草 Weed 0.953 ResNet 土壤 Soil 0.962 0.941 289.57 85.42 青菜 Vegetable 0.977 杂草 Weed 0.944 图3为各模型测试集混淆矩阵图,ShuffleNet分别将16张土壤图片和11张青菜图片错误地预测为杂草,同时分别将24张、13张杂草图片错误预测为土壤和青菜。由此可知,ShuffleNet对杂草的检测精度最高,而对青菜和土壤的检测精度与其他2种模型接近。

此外,研究还跟踪了3种模型对网格图像以及整张原图的识别速度,如表4所示。其中整图识别速度是指按照批处理方式,同时处理48张网格图像的速度。对于整图识别速度,所选的3种模型帧率均达50 fps以上,即速度均超过每秒50张图像的处理速度。在图像处理中,当帧率大于30 fps,即可认为实时处理。因此本研究中所选的3种模型,均达到了实时识别杂草的标准。其中,ResNet模型识别速度最快,为85.42 fps,而DenseNet模型效率最低,为58.94 fps。综合准确率和识别速度,在实时杂草识别的前提下,ShuffleNet模型的准确率最高,故而其为本次研究的最优模型。该结果与 ShuffleNet模型通过融合各个分组的特征,在降低计算量的同时保持了模型精度的特征相符[37]。

图4为精准除草作业区域检测效果图。包含青菜、杂草及土壤的原始图像被划分为若干网格。其中,第4行和第5行的前3个网格图像均包含杂草,为需要进行除草作业的区域(红色高亮区域)。在田间除草作业时,智能除草装备根据精准作业区域检测结果,将除草执行器移动至上述网格区域,实现精准除草。需要特别指出的是,第6行第3列的网格同时包含青菜和杂草,由于存在青菜,神经网络模型识别该网格为青菜图像,但此场景不会实质影响网格内杂草的清除,其主体部分所在网格(相邻第5行第3列)已被正确识别并标记为除草作业区域。

图5展示了模型推理过程中被错误识别的网格图像,分析后发现当青菜或杂草仅占图像极小部分时会导致误识别的发生。但此类场景并不会影响蔬菜田间杂草的防除,因为在此类场景中,杂草主体部分所在的网格区域会被正确识别并执行除草动作。此外,相应地增加此类场景的训练集图像也会有助于降低误识别。

3. 讨论与结论

本研究在训练神经网络模型时,将青菜归类为正样本,杂草和土壤归类为负样本。杂草种类繁多,若使用深度学习直接识别杂草,则需要搭建包含各种类杂草的图像训练集,即便如此,神经网络模型也难以准确识别所有种类的杂草。蔬菜种类有限,相比识别杂草,训练神经网络模型识别蔬菜可有效提升识别率。按照本文方法,神经网络仅需聚焦于识别蔬菜(正样本),未包含蔬菜的即为杂草或土壤,识别过程中不必关注图像中存在何种类的杂草,即对于神经网络而言,网格图像中未发现蔬菜,则其属于背景(负样本)。该归类方法可有效降低杂草识别复杂度,同时提高识别率。

精准除草的关键在于精准识别杂草并确定除草作业区域。当前也有相关研究采用目标检测方法,但相较于分类模型,目标检测模型需要对识别目标进行标注并绘制边界框(Bounding box),人工标注成本十分高昂。另一方面,包含杂草目标的边界框大小不一,而除草剂喷施器的喷施范围或机械除草执行器的单位作业范围通常是固定的,因而该边界框的区域并不能直接作为除草的作业区域。本研究通过将原始采集的图像切分为与除草执行器单位作业范围一致的网格区域,继而利用分类神经网络模型对网格图像进行识别,包含杂草的网格区域即认为是除草作业区域,该算法可直接集成至智能化除草装备的视觉系统,实现精准除草作业。

本研究选取ShuffleNet、DenseNet和ResNet神经网络模型开展了蔬菜田杂草识别与精准除草区域的研究。所选3种神经网络模型均能有效识别蔬菜、杂草和土壤。其中,ShuffleNet模型的平均识别准确率和识别速度最佳,分别为 0.951和68.37 fps,为本次研究的最优模型。通过将原图切分网格图像,利用深度学习模型进行识别,将包含杂草的网格图像标记为除草作业区域,以此实现蔬菜田精准除草作业区域的检测。研究结果表明,本文提出的除草作业区域检测方法具有高度的可行性和极佳的识别效果,有效降低了杂草识别的复杂度,同时提高了识别率,可用于蔬菜田间杂草的精准防除作业。

-

表 1 深度学习数据集

Table 1 Dataset of deep learning models

样本类别

Sample category正样本

Positive sample负样本

Negative sample青菜

Vegetable杂草

Weed土壤

Soil训练集

Training dataset3000 3000 3000 验证集

Validation dataset500 500 500 测试集

Testing dataset500 500 500 表 2 不同模型的默认超参数

Table 2 Hyper-parameters for training convolutional neural networks

模型

Neural network批尺寸

Batch size初始学习率

Initial learning rate学习率调整策略

Learning rate policy优化器

Optimizer训练周期

Training epochsShuffleNet 16 0.001 LambdaLR SGD 24 DenseNet 16 0.001 LambdaLR SGD 24 ResNet 16 0.0001 StepLR Adam 24 表 3 不同深度学习模型验证集识别结果

Table 3 Evaluation metrics on validation dataset obtained by deep learning models

模型

Neural Network类别

Category精度

Ppre召回率

PrecF1值

F1 scoreShuffleNet 土壤 Soil 0.978 0.946 0.967 青菜 Vegetable 0.990 0.988 0.989 杂草 Weed 0.955 0.970 0.962 DenseNet 土壤 Soil 0.972 0.974 0.973 青菜 Vegetable 0.975 0.994 0.984 杂草 Weed 0.969 0.948 0.958 ResNet 土壤 Soil 0.981 0.946 0.963 青菜 Vegetable 0.969 0.992 0.980 杂草 Weed 0.945 0.956 0.950 表 4 不同深度学习模型测试集评价数据

Table 4 Evaluation metrics on test dataset obtained by deep learning models

模型

Neural network类别

Category总体

准确率

OAcc平均

准确率

AAcc网格图像

识别

速度

Speed of

grid cells/fps原图识别

速度

Speed of

full images/fpsShuffleNet 土壤 Soil 0.967 0.951 207.45 68.37 青菜 Vegetable 0.978 杂草 Weed 0.957 DenseNet 土壤 Soil 0.967 0.949 104.05 58.94 青菜 Vegetable 0.979 杂草 Weed 0.953 ResNet 土壤 Soil 0.962 0.941 289.57 85.42 青菜 Vegetable 0.977 杂草 Weed 0.944 -

[1] 金月, 肖宏儒, 曹光乔, 等. 我国叶类蔬菜机械化水平现状与评价方法研究 [J]. 中国农机化学报, 2020, 41(12):196−201. JIN Y, XIAO H R, CAO G Q, et al. Research on status and evaluation methods of leafy vegetable mechanization production level in China [J]. Journal of Chinese Agricultural Mechanization, 2020, 41(12): 196−201. (in Chinese)

[2] 中华人民共和国国家统计局. 农业年度数据 [EB/OL]. http://data.stats.gov.cn/easyquery.htm?cn=C01. [3] 刘文, 徐丽明, 邢洁洁, 等. 作物株间机械除草技术的研究现状 [J]. 农机化研究, 2017, 39(1):243−250. LIU W, XU L M, XING J J, et al. Research status of mechanical intra-row weed control in row crops [J]. Journal of Agricultural Mechanization Research, 2017, 39(1): 243−250. (in Chinese)

[4] 强胜. 我国杂草学研究现状及其发展策略 [J]. 植物保护, 2010, 36(4):1−5. DOI: 10.3969/j.issn.0529-1542.2010.04.001 QIANG S. Current status and development strategy for weed science in China [J]. Plant Protection, 2010, 36(4): 1−5. (in Chinese) DOI: 10.3969/j.issn.0529-1542.2010.04.001

[5] 陈德润, 王书茂, 王秀. 农田杂草识别技术的现状与展望 [J]. 中国农机化, 2005, 26(2):35−38. CHEN D R, WANG S M, WANG X. Status and prospect for recognition technology of farm weeds [J]. Chinese Agriculture Mechanization, 2005, 26(2): 35−38. (in Chinese)

[6] 何义川, 汤智辉, 李光新, 等. 葡萄园除草技术研究现状与发展趋势 [J]. 中国农机化学报, 2018, 39(9):34−37. HE Y C, TANG Z H, LI G X, et al. Research on current status and developing tendency of the vineyard weeding [J]. Journal of Chinese Agricultural Mechanization, 2018, 39(9): 34−37. (in Chinese)

[7] 李东升, 张莲洁, 盖志武, 等. 国内外除草技术研究现状 [J]. 森林工程, 2002, 18(1):17−18. LI D S, ZHANG L J, GAI Z W, et al. Research situations of weeding techniques in abroad and home [J]. Forest Engineering, 2002, 18(1): 17−18. (in Chinese)

[8] 洪晓玮, 陈勇, 杨超淞, 等. 有机蔬菜大棚除草机器人研制 [J]. 制造业自动化, 2021, 43(5):33−36,71. HONG X W, CHEN Y, YANG C S, et al. Development of a weeding robot for organic vegetable greenhouse [J]. Manufacturing Automation, 2021, 43(5): 33−36,71. (in Chinese)

[9] HASANUZZAMAN M, MOHSIN S M, BHUYAN M H M B, et al. Phytotoxicity, environmental and health hazards of herbicides: Challenges and ways forward[M]//Agrochemicals Detection, Treatment and Remediation. Amsterdam: Elsevier, 2020: 55-99.

[10] 何荣昌. 浅析农田除草剂对土壤生态环境的影响 [J]. 南方农业, 2019, 13(6):187−188. HE R C. Analysis on the influence of herbicide on soil ecological environment in farmland [J]. South China Agriculture, 2019, 13(6): 187−188. (in Chinese)

[11] 东辉, 陈鑫凯, 孙浩, 等. 基于改进YOLOv4和图像处理的蔬菜田杂草检测 [J]. 图学学报, 2022, 43(4):559−569. DONG H, CHEN X K, SUN H, et al. Weed detection in vegetable field based on improved YOLOv4 and image processing [J]. Journal of Graphics, 2022, 43(4): 559−569. (in Chinese)

[12] 兰天, 李端玲, 张忠海, 等. 智能农业除草机器人研究现状与趋势分析 [J]. 计算机测量与控制, 2021, 29(5):1−7. LAN T, LI D L, ZHANG Z H, et al. Analysis on research status and trend of intelligent agricultural weeding robot [J]. Computer Measurement & Control, 2021, 29(5): 1−7. (in Chinese)

[13] 马娟, 董金皋. 微生物除草剂与生物安全 [J]. 植物保护, 2006, 32(1):9−12. MA J, DONG J G. Microbial herbicides and biosafety [J]. Plant Protection, 2006, 32(1): 9−12. (in Chinese)

[14] 金小俊, 孙艳霞, 陈勇, 等. 基于深度学习的草坪杂草识别与除草剂喷施区域检测方法 [J]. 草地学报, 2022, 30(6):1543−1549. JIN X J, SUN Y X, CHEN Y, et al. Weed recognition and herbicide spraying area detection in turf based on deep learning [J]. Acta Agrestia Sinica, 2022, 30(6): 1543−1549. (in Chinese)

[15] 孙艳霞, 陈燕飞, 金小俊, 等. 基于人工智能的青菜幼苗与杂草识别方法 [J]. 福建农业学报, 2021, 36(12):1484−1490. SUN Y X, CHEN Y F, JIN X J, et al. AI differentiation of Bok choy seedlings from weeds [J]. Fujian Journal of Agricultural Sciences, 2021, 36(12): 1484−1490. (in Chinese)

[16] 朱伟兴, 金飞剑, 谈蓉蓉. 基于颜色特征与多层同质性分割算法的麦田杂草识别[J]. 农业机械学报, 2007, 38(12): 120−124. ZHU W X, JIN F J, TAN R R. Weed recognition method based on color feature and hierarchical homogeneity segmentation in wheat field[J]. Transactions of the Chinese Society for Agricultural Machinery, 2007, 38(12): 120−124. (in Chinese)

[17] BURGOS-ARTIZZU X P, RIBEIRO A, GUIJARRO M, et al. Original paper: Real-time image processing for crop/weed discrimination in maize fields [J]. Computers and Electronics in Agriculture, 2011, 75(2): 337−346.

[18] BAKHSHIPOUR A, JAFARI A, NASSIRI S M, et al. Weed segmentation using texture features extracted from wavelet sub-images [J]. Biosystems Engineering, 2017, 157: 1−12. DOI: 10.1016/j.biosystemseng.2017.02.002

[19] 杨涛, 李晓晓. 机器视觉技术在现代农业生产中的研究进展 [J]. 中国农机化学报, 2021, 42(3):171−181. YANG T, LI X X. Research progress of machine vision technology in modern agricultural production [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(3): 171−181. (in Chinese)

[20] 赵娜, 赵平, 高轶军. 机器视觉技术在我国现代农业生产中的应用研究 [J]. 天津农学院学报, 2015, 22(2):55−58. ZHAO N, ZHAO P, GAO Y J. Study on application of machine vision technology to modern agriculture in China [J]. Journal of Tianjin Agricultural University, 2015, 22(2): 55−58. (in Chinese)

[21] 刘现, 郑回勇, 施能强, 等. 人工智能在农业生产中的应用进展 [J]. 福建农业学报, 2013, 28(6):609−614. LIU X, ZHENG H Y, SHI N Q, et al. Artificial intelligence in agricultural applications [J]. Fujian Journal of Agricultural Sciences, 2013, 28(6): 609−614. (in Chinese)

[22] OSORIO K, PUERTO A, PEDRAZA C, et al. A deep learning approach for weed detection in lettuce crops using multispectral images [J]. AgriEngineering, 2020, 2(3): 471−488. DOI: 10.3390/agriengineering2030032

[23] 彭文, 兰玉彬, 岳学军, 等. 基于深度卷积神经网络的水稻田杂草识别研究 [J]. 华南农业大学学报, 2020, 41(6):75−81. DOI: 10.7671/j.issn.1001-411X.202007029 PENG W, LAN Y B, YUE X J, et al. Research on paddy weed recognition based on deep convolutional neural network [J]. Journal of South China Agricultural University, 2020, 41(6): 75−81. (in Chinese) DOI: 10.7671/j.issn.1001-411X.202007029

[24] YU J L, SCHUMANN A W, SHARPE S M, et al. Detection of grassy weeds in bermudagrass with deep convolutional neural networks [J]. Weed Science, 2020, 68(5): 545−552. DOI: 10.1017/wsc.2020.46

[25] YU J L, SHARPE S M, SCHUMANN A W, et al. Deep learning for image-based weed detection in turfgrass [J]. European Journal of Agronomy, 2019, 104: 78−84. DOI: 10.1016/j.eja.2019.01.004

[26] YU J L, SCHUMANN A W, CAO Z, et al. Weed detection in perennial ryegrass with deep learning convolutional neural network [J]. Frontiers in Plant Science, 2019, 10: 1422. DOI: 10.3389/fpls.2019.01422

[27] 金小俊, 孙艳霞, 于佳琳, 等. 基于深度学习与图像处理的蔬菜苗期杂草识别方法 [J]. 吉林大学学报(工学版), 2023, 53(8):2421−2429. JIN X J, SUN Y X, YU J L, et al. Weed recognition in vegetable at seedling stage based on deep learning and image processing [J]. Journal of Jilin University:Engineering and Technology Edition, 2023, 53(8): 2421−2429.

[28] JIN X J, SUN Y X, CHE J, et al. A novel deep learning-based method for detection of weeds in vegetables [J]. Pest Management Science, 2022, 78(5): 1861−1869. DOI: 10.1002/ps.6804

[29] JIN X J, CHE J, CHEN Y. Weed identification using deep learning and image processing in vegetable plantation [J]. IEEE Access, 2021, 9: 10940−10950. DOI: 10.1109/ACCESS.2021.3050296

[30] 毛文华, 姜红花, 胡小安, 等. 基于位置特征的行间杂草识别方法 [J]. 农业机械学报, 2007, 38(11):74−76,83. DOI: 10.3969/j.issn.1000-1298.2007.11.018 MAO W H, JIANG H H, HU X A, et al. Between-row weed detection method based on position feature [J]. Transactions of the Chinese Society for Agricultural Machinery, 2007, 38(11): 74−76,83. (in Chinese) DOI: 10.3969/j.issn.1000-1298.2007.11.018

[31] PYTORCH. Tensors and dynamic neural networks in python with strong GPU acceleration. [DB/OL]. (2020-01-18)[2020-03-05]. https://github.com/pytorch/pytorch.

[32] 舒娜, 刘波, 林伟伟, 等. 分布式机器学习平台与算法综述 [J]. 计算机科学, 2019, 46(3):9−18. DOI: 10.11896/j.issn.1002-137X.2019.03.002 SHU N, LIU B, LIN W W, et al. Survey of distributed machine learning platforms and algorithms [J]. Computer Science, 2019, 46(3): 9−18. (in Chinese) DOI: 10.11896/j.issn.1002-137X.2019.03.002

[33] 黄海松, 陈星燃, 韩正功, 等. 基于多尺度注意力机制和知识蒸馏的茶叶嫩芽分级方法 [J]. 农业机械学报, 2022, 53(9):399−407,458. HUANG H S, CHEN X R, HAN Z G, et al. Tea buds grading method based on multiscale attention mechanism and knowledge distillation [J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(9): 399−407,458. (in Chinese)

[34] 李子茂, 徐杰, 郑禄, 等. 基于改进DenseNet的茶叶病害小样本识别方法 [J]. 农业工程学报, 2022, 38(10):182−190. LI Z M, XU J, ZHENG L, et al. Small sample recognition method of tea disease based on improved DenseNet [J]. Transactions of the Chinese Society of Agricultural Engineering, 2022, 38(10): 182−190. (in Chinese)

[35] GAO S H, CHENG M M, ZHAO K, et al. Res2Net: A new multi-scale backbone architecture [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(2): 652−662. DOI: 10.1109/TPAMI.2019.2938758

[36] 吕梦棋, 张芮祥, 贾浩, 等. 基于改进ResNet玉米种子分类方法研究 [J]. 中国农机化学报, 2021, 42(4):92−98. LÜ M Q, ZHANG R X, JIA H, et al. Research on seed classification based on improved ResNet [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(4): 92−98. (in Chinese)

[37] HANG X Y, ZHOU X Y, LIN M X, et al. ShuffleNet: an extremely efficient convolutional neural network for mobile devices[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT. IEEE, 2018: 6848-6856.

下载:

下载: